على مدار الأيام الماضية، كانت شركة أبل في دائرة الضوء مع الكثير من الانتقادات بسبب ميزة فحص الصور بأجهزتها والتي أطلقتها لحماية الأطفال ومنع الإساءة إليهم أو استغلالهم أو ما يعرف بصور CSAM، وأعربت العديد من منظمات الخصوصية وحتى الخبراء عن قلقهم بشأن تحوّل تلك الميزة إلى ثغرة يمكن للهاكرز أو حتى الحكومات استغلالها لانتهاك خصوصية مستخدمي الآي-فون، ومن أجل إزالة أي لبس أو لغط وتفسير الأمور بالشكل الصحيح أطلقت أبل ملف على شكل أسئلة شائعة يشرح كل شيء عن ميزتها الجديدة وما يحدث خلف الكواليس، ولنتعرف على كل شيء حول ميزة سلامة الأطفال وهل فعلا تهدد خصوصية المستخدمين أم لا.

ما الاختلاف بين نظام الحماية في الرسائل وميزة CSAM في صور iCloud؟

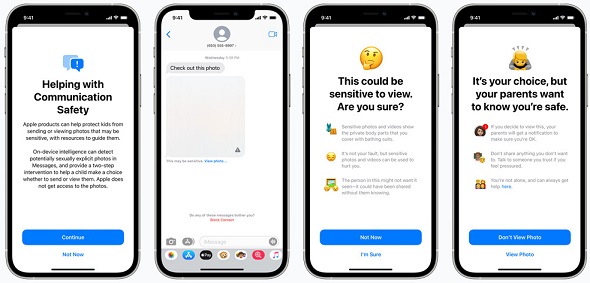

هاتان الميزتان مختلفتان ولا تستخدمان نفس التقنية حيث تم تصميم أمان الاتصال في الرسائل لمنح الآباء والأطفال أدوات إضافية للمساعدة في حماية أطفالهم من إرسال واستقبال صور جنسية صريحة في تطبيق الرسائل. إنه يعمل فقط على الصور المرسلة أو المستلمة في تطبيق الرسائل لحسابات الأطفال التي تم إعدادها من خلال Family Sharing ثم يقوم بتحليل الصور الموجودة على الجهاز وبالتالي لا يتعرض لخصوصية للرسائل وعندما يرسل حساب طفل أو يتلقى صوراً جنسية، يتم التشويش على الصورة ويتم تحذير الطفل وتزويده بمصادر مفيدة وطمأنته أنه لا بأس إذا لم يرغب في عرض الصورة أو إرسالها وكإجراء احترازي إضافي، يمكن أيضا إخبار الأطفال الصغار أنه للتأكد من سلامتهم، سيتلقى والديهم رسالة إذا شاهدوها.

الميزة الثانية، وهي فحص الصور CSAM في iCloud وهي مصممة لإبقاء CSAM خارج iCloud Photos دون تقديم معلومات إلى أبل حول أي صور غير تلك التي تتطابق مع صور CSAM المعروفة. يعد امتلاك صور CSAM أمراً غير قانوني في معظم البلدان، بما في ذلك الولايات المتحدة. كما أن هذه الميزة تؤثر فقط على المستخدمين الذين اختاروا استخدام صور iCloud لتخزين صورهم ولا يؤثر ذلك على المستخدمين الذين لم يختاروا استخدام صور iCloud. ليس هناك أي تأثير على أي بيانات أخرى على الجهاز وتلك الميزة لا تنطبق على الرسائل.

من يمكنه استخدام أمان الاتصال في الرسائل؟

أمان الاتصالات في الرسائل متاح فقط للحسابات التي تم إعدادها كعائلات في iCloud. يجب أن يختار الوالدين أو الوصي تفعيل الميزة للعائلة ولا يمكن تمكين إشعارات الوالدين إلا من قِبل الآباء أو الأوصياء لحسابات الأطفال الذين يبلغون من العمر 12 عامًا أو أقل.

هل هذا يعني أن الرسائل سيتم مشاركتها مع أبل أو وكالات إنفاذ القانون؟

بالطبع لا، لن تتمكن أبل أبدا من الوصول إلى المعلومات في الرسائل كنتيجة لهذه الميزة في الرسائل. لا تشارك هذه الميزة أي معلومات مع Apple أو المركز الوطني للأطفال المفقودين والمستغلين NCMEC أو وكالات إنفاذ القانون. ميزة أمان الاتصالات في الرسائل منفصلة عن ميزة CSAM لفحص صور iCloud.

هل يؤدي هذا إلى كسر التشفير التام في تطبيق الرسائل؟

لا. لا يؤدي هذا إلى انتهاك بشأن الخصوصية للرسائل، ولن تتمكن أبل أبدًا من الوصول إلى جهات الاتصال نتيجة لهذه الميزة. أي مستخدم لتطبيق الرسائل بما في ذلك أولئك الذين تم تمكين أمان الاتصال بهم، يتحكم تماما بما يتم ارساله ولمن.

إذا تم تمكين الميزة لحساب الطفل، فسيقوم الجهاز بتقييم الصور في الرسائل وتقديم تدخل إذا تم تحديد الصورة على أنها غير ملائمة وبالنسبة لحسابات الأطفال الذين تقل أعمارهم عن 12 عاما، يمكن للوالدين إعداد إشعارات الوالدين التي سيتم إرسالها إذا أكد الطفل وأرسل أو شاهد صورة تم تحديد أنها غير ملائمة ولا يمكن لشركة أبل الوصول إلى الرسائل أو التدخل في الإخطارات أو تقييم الصور.

هل هذه الميزة تمنع الأطفال الذين يشعرون بالإساءة من طلب المساعدة؟

تنطبق ميزة أمان الاتصال فقط على الصور الجنسية الصريحة التي يتم مشاركتها أو استلامها في الرسائل ولا علاقة لها بالتطبيقات الأخرى التي يمكن للضحايا استخدامها لطلب المساعدة، بما في ذلك الرسائل النصية كما يمكن لسيري أو عمليات البحث، تزويد الضحايا أو الأشخاص الذين يعرفون الضحايا، بمزيد من الإرشادات حول كيفية طلب المساعدة.

هل سيتم إخطار الوالدين دون تحذير الأطفال وإعطائهم خيار؟

لا. أولاً؛ يجب على حسابات الوالدين أو الوصي الاشتراك لتمكين أمان الاتصال في الرسائل كما يتم تفعيل إشعارات الوالدين لحسابات الأطفال الذين يبلغون من العمر 12 عاما أو أقل ولكن قبل ذلك، أي صورة فاضحة أو غير ملائمة يتم إرسالها أو استلامها، يتم تحذير الطفل من أنه إذا استمر في عرض الصورة أو إرسالها، سيتم إرسال إشعار إلى والديه وإذا استمر الطفل في إرسال أو عرض صورة بعد هذا التحذير، يتم ابلاغ الآباء أما حسابات الأطفال الذين تتراوح أعمارهم بين 13 و 17 عاما، لا يزال يتم تحذير الطفل وسؤاله عما إذا كان يرغب في عرض أو مشاركة صورة جنسية، ولكن لا يتم إخطار الوالدين.

هل هذا يعني أن أبل ستقوم بفحص جميع الصور المخزنة على جهازي ؟

تنطبق هذه الميزة فقط على الصور التي يختار المستخدم تحميلها علىiCloud ولا تعمل الميزة مع المستخدمين الذين لديهم صور iCloud معطلة كما أنها لا تعمل أيضا على مكتبة الصور الموجودة على جهاز الآي-فون الخاص بك.

هل يتم تنزيل صور CSAM على جهازي لمطابقتها بالصور الخاصة بي؟

لا، لا يتم تخزين صور CSAM على الجهاز أو إرسالها إليه. بدلاً من الصور الفعلية، تستخدم أبل تجزئات غير قابلة للقراءة مخزنة على الجهاز. هذه التجزئات عبارة عن سلاسل من الأرقام التي تمثل صور CSAM المعروفة، ولكن لا يمكن قراءتها أو تحويلها إلى صور غير ملائمة مرة أخرى. تستند هذه المجموعة من تجزئات الصور إلى الصور التي تم الحصول عليها والتحقق من صحتها باعتبارها CSAM بواسطة منظمات سلامة الأطفال. باستخدام التطبيقات الجديدة للتشفير، تستطيع أبل استخدام هذه التجزئات للتعرف فقط على حسابات iCloud التي تخزن مجموعات من الصور التي تتطابق مع صور CSAM المعروفة وبعد ذلك تكون قادرة فقط على التعرف على صور الأطفال الغير ملائمة ودون التعرف على أي صور أخرى أو رؤيتها.

لماذا الآن؟

تتمثل إحدى التحديات الكبيرة لشركة أبل، تقديم المساعدة لحماية الأطفال مع الحفاظ على خصوصية المستخدمين. باستخدام الميزة الجديدة، سوف تكتشف أبل صور CSAM التي يتم تخزينها فيiCloud ولن تتعلم الشركة أي شيء عن البيانات الأخرى المخزنة على جهازك.

تقوم التقنيات الحالية التي تعتمد عليها الشركات الأخرى بفحص جميع صور المستخدم المخزنة في السحابة. هذا يخلق مخاطر بالنسبة لخصوصية المستخدمين ولكن الأمر مختلف مع ميزة فحص الصور من أبل مثل عدم القدرة على التعرف على الصور ما لم يتطابق كلاهما مع صور CSAM المعروفة وتم تضمينهما في حساب iCloud الذي يتضمن العديد من صور CSAM المتعارف عليها.

هل يمكن استخدام نظام الكشف عن صور CSAM في iCloud للكشف أشياء أخرى؟

قالت أبل أن تصميم العملية لمنع حدوث ذلك. تم تصميم اكتشاف صور CSAM من أجل صور أي- كلاود بحيث يعمل النظام فقط مع تجزئات صور CSAM التي توفرها NCMEC ومنظمات سلامة الأطفال الأخرى.

تستند هذه المجموعة من تجزئات الصور إلى الصور التي تم الحصول عليها والتحقق من صحتها باعتبارها CSAM بواسطة منظمات سلامة الأطفال. لا يوجد إبلاغ آلي إلى سلطات إنفاذ القانون، وتُجري أبل مراجعة بشرية قبل تقديم تقريرها إلى المركز الوطني للأطفال المفقودين والمستغلين NCMEC.

نتيجة لذلك، تم تصميم النظام فقط للإبلاغ عن الصور المعروفة بـ CSAM في صور iCloud. في معظم البلدان، بما في ذلك الولايات المتحدة، حيث يعد امتلاك هذه الصور جريمة وتلتزم أبل بالإبلاغ عن أي حالات نعلم بها إلى السلطات المختصة.

هل يمكن للحكومات إجبار أبل على إضافة صور غير CSAM إلى ملف قائمة التجزئة؟

سوف ترفض شركة أبل أي مطالب من هذا القبيل. تم تصميم قدرة اكتشاف CSAM لاكتشاف صور CSAM المعروفة والمخزنة في iCloud Photos فقط والتي تم تحديدها من قبل الخبراء في NCMEC ومجموعات سلامة الأطفال الأخرى.

لقد واجهنا مطالب لبناء ونشر التغييرات التي فرضتها الحكومة والتي تقوض خصوصية المستخدمين من قبل، ورفضنا هذه المطالب بثبات. سوف نستمر في رفضها في المستقبل. لنكن واضحين، تقتصر هذه التقنية على اكتشاف CSAM المخزنة في iCloud ولن نوافق على أي طلب حكومي قد يشمل ملفات أخرى.

علاوة على ذلك، تُجري أبل مراجعة بشرية قبل تقديم تقرير إلى NCMEC. في حالة قيام النظام بوضع علامة على الصور التي لا تتطابق مع صور CSAM المعروفة، لن يتم تعطيل الحساب ولن يتم تقديم أي تقرير إلى NCMEC.

هل يمكن تخصيص CSAM لاستهداف أشياء أخرى أو أشخاص محددين؟

تم تصميم عمليتنا لمنع حدوث ذلك. مجموعة تجزئات الصور المستخدمة للمطابقة مأخوذة من صور معروفة وموجودة لـ CSAM والتي تم الحصول عليها والتحقق من صحتها من قبل منظمات سلامة الأطفال كما يتم تخزين نفس مجموعة التجزئة في نظام التشغيل لكل مستخدم آي-فون وآي-باد، لذلك فإن الهجمات المستهدفة ضد أفراد معينين فقط غير ممكنة بموجب تصميمنا كما لا يوجد إبلاغ آلي إلى سلطات إنفاذ القانون، وتُجري أبل مراجعة بشرية قبل تقديم تقريرها، وفي حالة عدم احتمال قيام النظام بوضع علامة على الصور التي لا تتطابق مع صور CSAM المعروفة، فلن يتم تعطيل الحساب ولن يتم تقديم أي تقرير.

هل قد يحدث خطأ لأشخاص أبرياء بسبب الميزة؟

لا، لقد تم تصميم النظام بحيث يكون دقيقا للغاية، واحتمالية قيام النظام بوضع علامة غير صحيحة على أي حساب معين أقل من واحد من كل تريليون حساب سنويا بالإضافة إلى ذلك، في أي وقت يتم فيه تمييز حساب من قبل النظام، تُجري أبل مراجعة بشرية قبل تقديم تقريرها إلى NCMEC ونتيجة لذلك، لن تؤدي أخطاء النظام أو الهجمات إلى الإبلاغ عن الأبرياء.

المصدر:

لقد طمأنني هذا المقال الى درجة كبيرة من عدم استغلال ابل اوغيرها للخصوصية

ارى ان هذا تفصيل ومجهود في غير محله فالاولى ان تكثف ابل جهودها في حل مشكلة استنزاف بطارياتها بسرعة واضافة التطبيقات التى يحتاجها المستخدم ويفتقدها مقارنة بتطبيقات اندرويد وكمثال كنت املك موبايل لوميا ٩٥٠ xl وكان يوجد به ضمن برامج النظام ودون الحاجة لاضافة تطبيق او شراؤه نظام تسجيل المكالمات واكرر ضمن برامج النظام فلماذا لا تهتم ابل بما يفيد المستخدم اكثر من تضيع وقتها في الاستعراض بتطبيقات تدعي انها تخدم المجتمع في الوقت التي تثير فيه الشبهات حول الغرض الحقيقي من تطبيق مثل حمايه الطفال من الصور الضاره !!!!؟؟؟

حقيقة الموضوع مقلق..

أبل ليست مركز شرطة ولا وكالة استخبارات..

لديها عشرات الوسائل لمساعدة الأطفال..

ممكن ان نطمئن إذا استطعنا الثقة التامة في أبل وكلامها وتصريحاتها.. ولكن..

لا أعتقد أن أبل ولا غيرها تمتلك ذلك الصدق المطلق لأننا نعيش في عالم مليء بالاكاذيب التي تحكمها المصالح !!

شكرا لكم على هذا الموضوع الجميل

مجهود تشكرون عليه

شركة تهتم بمحاربة استغلال الاطفال

وشركات تهتم بالشاحن 65 واط و200 واط

وبالكاميرا 108 بكسل

🙃🙃🙃

ان شاءالله خير وتبقي الخصوصية في الايفون

من نافلة القول أن نذكر عزيزنا القارئ بكيفية اتخاذ التفاحة للقرارات، وهي بكل بساطة أن تكون مدروسة من جميع الجوانب القانونية والعملية خاصة وأنها أي التفاحة تقدم نموذجاً منقطع النظير بإدارة الخصوصية والأمان للمستخدم.

لذا يا عزيزي هل تصدق أن التفاحة ستضحي بتاريخها من أجل صورة.

هذه الخدمة رائعة وعالية الموثوقية بعد هذا الشرح الطويل بالمقال، خاصة أنها تتعلق بأمن الأطفال وهي اختيارية بالمناسبة.

فإن كنت من أنصار نظرية المؤامرة في كل مستحدث -وما أكثرهم في عالمنا العربي المشوه بالشبهات- فلا حاجة لك بها، وضع أمن أطفالك بيد المتآمرين الحقيقيين.

وإن كنت تفهم ما قيل فلا بأس من التجربة على الأقل أو الانتظار بضع سينين للتأكد.

حَرِيٌّ بنا أن نتخلص من عقليات المؤامرة وأجدر لنا أن نفهم تفاصيل الأمور بروية، صحيح أننا تعودنا على كثير من المؤامرات ولكن أن تعمى البصيرة لتمتد لكل مستجد فهذا بوابة التخلف التي يجب أن توصد وليس موضوع لقاحات الكورونا ببعيد عن تلكم المهاترات.

لو كنت متابع للموضوع لعرفت أنه ليس العرب من وضعوا نظريات المؤامرة هنا

بل المواقع والحسابات الأمريكية نفسها.

انا اري الامر جيد من الجيد الاهتمام بالاطفال شكرا ابل 👏🏻

السلام عليكم

لديك مشكلة لا اعلم ان كانت مشكلة ام لا

جهاز هو ايباد 8 ويعمل بشكل رائع

بعد تحديث الجهاز ربما كان تحديث 14.5 اصبح صوت الاشعارات ضعيفا

عند دخول الاعدادات وتعين نغمة رنين يكون الصوت قويا جدا وصوت الالعاب واليوتيوب وكل البرامج

لكن عند تعيين نغمة الرسائل او البريد او اي شيئ اخر يكون الصوت ضعيفا وصوت الشعارات ايضا

هل هذا عند كل الاجهزة ام فقط جهازي ام هناك شيء في الاعدادات يجب تغييره

هذي ميزه مش بج

لما تكون عيونك على الايباد راح يكون خافت صوت الاشعار ولما تكون مغلق الشاشة او غير منتبه لها صوت الإشعار يكون طبيعي عالي

طيب وفي حالة الخطأ هل تعوض أبل المستخدمين الذين خضعت صورهم لمراجعة بشرية وتم انتهاك خصوصيتهم بالاطلاع على صورهم دون إذن؟

وهل سيتم إخطارهم أصلا؟

أليس الأصل في القوانين هو عدم التفتيش عن الممنوعات إلا في وجود شبهة على شخص بعينه وبسبب؟

هل هناك قانون يجيز ويقر بأن الأصل هو إخضاع جميع المحتويات للتدقيق والتفتيش لكل الناس حتى ولو كان تدقيقا آليا؟

أليس المواطنون أمام القانون سواسية؟ فماذا عن مستخدمي الأنظمة الأخرى؟

كلشي تسويه ابل راضي …# معاً _ يا _ ابل🎧💪🏻

السلام عليكم ورحمة الله

كيف اعرف الماك أدرس بتاع الايفون ، وازاي اضيفه علي الراوتر

ولكم جزيل الشكر

ادخل الاعدادات general -> about

بتحصل WiFi address

وأيضًا ابحث في جوجل ستجد الكثيرين يشرحون ما تطلبه، على كل أظن يستحسن إيقاف private address من إعدادات ال Wifi لأنه يعين Mac Address مختلف مع كل اتصال لحمايتك