Negli ultimi giorni, Apple è stata sotto i riflettori con molte critiche dovute a Funzione di scansione delle immagini Con i suoi dispositivi, che ha lanciato per proteggere i bambini e prevenire abusi o sfruttamento di loro, o le cosiddette immagini CSAM, e molte organizzazioni per la privacy e persino esperti hanno espresso preoccupazione per la trasformazione di questa funzione in una scappatoia che gli hacker o persino i governi può sfruttare per violare la privacy degli utenti iPhone, e al fine di rimuovere qualsiasi confusione o chiarire e spiegare le cose correttamente.Apple ha lanciato un file sotto forma di FAQ che spiega tutto sulla sua nuova funzionalità e cosa sta accadendo dietro le quinte, e andiamo scopri tutto sulla funzione di sicurezza dei bambini e se minaccia davvero la privacy degli utenti o meno.

Qual è la differenza tra Message Protection e CSAM in iCloud Photos?

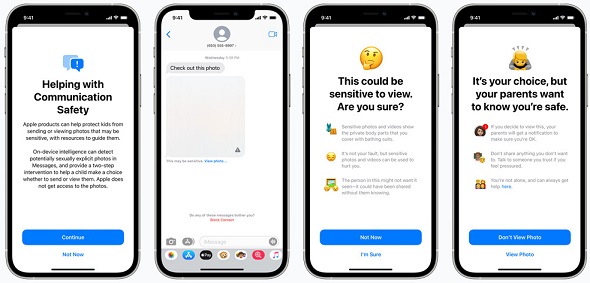

Queste due funzionalità sono diverse e non utilizzano la stessa tecnologia in quanto Communication Security in Messages è progettata per fornire a genitori e figli strumenti aggiuntivi per proteggere i propri figli dall'invio e dalla ricezione di immagini sessualmente esplicite nell'app Messaggi. Funziona solo sulle foto inviate o ricevute nell'app Messaggi per gli account dei bambini configurata con Family Sharing e quindi analizza le foto sul dispositivo e quindi non espone la privacy dei messaggi.Utile e rassicurante che va bene se lo fa' t desidera visualizzare o inviare l'immagine e, come ulteriore precauzione, ai bambini piccoli può anche essere detto che per la loro sicurezza, i loro genitori riceveranno un messaggio se lo vedono.

La seconda funzione, Scansione foto CSAM in iCloud, è progettata per mantenere CSAM fuori da Foto di iCloud senza fornire informazioni ad Apple su foto diverse da quelle che corrispondono a foto CSAM note. Il possesso di immagini CSAM è illegale nella maggior parte dei paesi, compresi gli Stati Uniti. Inoltre, questa funzione riguarda solo gli utenti che hanno scelto di utilizzare Foto di iCloud per archiviare le proprie foto e non riguarda gli utenti che non hanno scelto di utilizzare Foto di iCloud. Non ci sono effetti su altri dati sul dispositivo e questa funzione non si applica ai messaggi.

Chi può utilizzare la sicurezza della connessione nei messaggi?

La sicurezza delle comunicazioni in Messaggi è disponibile solo per gli account configurati come famiglie in iCloud. I genitori o i tutori devono scegliere di abilitare la funzione per la famiglia e le notifiche ai genitori possono essere abilitate solo dai genitori o dai tutori degli account per bambini di età pari o inferiore a 12 anni.

Questo significa che i messaggi verranno condivisi con Apple o con le forze dell'ordine?

Ovviamente no, Apple non sarà mai in grado di accedere alle informazioni in Messaggi a causa di questa funzione in Messaggi. Questa funzione non condivide alcuna informazione con Apple, NCMEC o le forze dell'ordine. La funzione di sicurezza delle comunicazioni in Messaggi è separata dalla funzione CSAM per iCloud Photo Scan.

Questo interrompe la crittografia end-to-end nell'app Messaggi?

No. Ciò non comporta una violazione della privacy per i messaggi e Apple non sarà mai in grado di accedere ai tuoi contatti a causa di questa funzione. Qualsiasi utente dell'app Messaggi, inclusi quelli che hanno abilitato la sicurezza dei contatti, ha il controllo completo su cosa viene inviato e a chi.

Se la funzione è abilitata per l'account di un bambino, il dispositivo valuterà le immagini nei messaggi e fornirà un intervento se un'immagine viene identificata come inappropriata.È inappropriata e Apple non può accedere ai messaggi, interferire con le notifiche o valutare le foto.

Questa funzione impedisce ai bambini abusati di chiedere aiuto?

La funzione di sicurezza della connessione si applica solo alle immagini sessualmente esplicite condivise o ricevute nei messaggi e non ha nulla a che fare con altre app che le vittime possono utilizzare per chiedere aiuto, inclusi i messaggi di testo Istruzioni su come cercare aiuto.

I genitori saranno avvisati senza avvisare i bambini e dare loro una scelta?

No. Oh no; Gli account genitore o tutore devono registrarsi per abilitare la sicurezza della comunicazione nei messaggi Le notifiche dei genitori sono abilitate per gli account di bambini di età pari o inferiore a 12 anni, ma prima di ciò, viene inviata o ricevuta qualsiasi immagine oscena o inappropriata, il bambino viene avvisato che se continuano per visualizzare o inviare l'immagine, verrà inviata una notifica ai genitori e se il bambino continua a inviare o visualizzare un'immagine dopo questo avviso, i genitori vengono avvisati Per gli account di bambini di età compresa tra 13 e 17 anni, il bambino viene comunque avvisato e gli viene chiesto se vorrebbero visualizzare o condividere una foto sessuale, ma i genitori non vengono avvisati.

Questo significa che Apple controllerà tutte le foto archiviate sul mio dispositivo?

Questa funzione si applica solo alle foto che l'utente sceglie di caricare su iCloud.La funzione non funziona con gli utenti che hanno disabilitato le foto di iCloud e non funziona nemmeno sulla libreria di foto sul tuo iPhone.

Le immagini CSAM vengono scaricate sul mio dispositivo in modo che corrispondano alle mie immagini?

No, le immagini CSAM non vengono archiviate o inviate al dispositivo. Invece di immagini reali, Apple utilizza hash illeggibili memorizzati sul dispositivo. Questi hash sono stringhe di numeri che rappresentano immagini CSAM note, ma non possono essere lette o convertite nuovamente in immagini irrilevanti. Questo set di hash delle immagini si basa su immagini ottenute e convalidate come CSAM dalle organizzazioni per la sicurezza dei bambini. Con le nuove applicazioni di crittografia, Apple può utilizzare questi hash per identificare solo gli account iCloud che archiviano lotti di foto che corrispondono a foto CSAM note e quindi essere in grado di identificare solo le foto dei bambini inappropriate senza riconoscere o vedere altre foto.

perché ora?

Una delle grandi sfide di Apple è aiutare a proteggere i bambini preservando la privacy degli utenti. Con la nuova funzionalità, Apple rileverà le foto CSAM archiviate in iCloud e l'azienda non apprenderà nulla sugli altri dati archiviati sul dispositivo.

Le tecnologie esistenti su cui si affidano altre aziende scansionano tutte le immagini degli utenti archiviate nel cloud. Ciò crea rischi per la privacy per gli utenti, ma è diverso con la funzione Scansione foto di Apple, ad esempio non essere in grado di riconoscere le foto a meno che non corrispondano a foto CSAM note e siano incluse in un account iCloud che include molte foto CSAM canoniche.

Il sistema di rilevamento delle immagini CSAM di iCloud può essere utilizzato per rilevare altre cose?

Apple ha detto che la progettazione del processo per evitare che ciò accada. Il rilevamento delle immagini CSAM è progettato per le immagini iCloud in modo che il sistema funzioni solo con gli hash delle immagini CSAM forniti da NCMEC e altre organizzazioni per la sicurezza dei bambini.

Questo set di hash delle immagini si basa su immagini ottenute e convalidate come CSAM dalle organizzazioni per la sicurezza dei bambini. Non esiste alcuna segnalazione automatica alle forze dell'ordine e Apple conduce una revisione umana prima di inviare la sua segnalazione al National Center for Missing and Exploited Children (NCMEC).

Di conseguenza, il sistema è progettato solo per segnalare foto note come CSAM in iCloud Photos. Nella maggior parte dei paesi, inclusi gli Stati Uniti, il possesso di queste immagini è un reato e Apple è obbligata a segnalare alle autorità competenti i casi di cui venissimo a conoscenza.

I governi possono costringere Apple ad aggiungere immagini non CSAM a un file di elenco hash?

Apple rifiuterà tali richieste. La funzionalità di rilevamento CSAM è progettata per rilevare solo le foto CSAM note archiviate in iCloud Photos che sono state identificate da esperti di NCMEC e altri gruppi per la sicurezza dei bambini.

Abbiamo già affrontato richieste di creare e pubblicare modifiche imposte dal governo che minano la privacy degli utenti e abbiamo fermamente rifiutato queste richieste. Continueremo a rifiutarlo in futuro. Per essere chiari, questa tecnologia è limitata al rilevamento di CSAM archiviato in iCloud e non approveremo alcuna richiesta del governo che possa coinvolgere altri file.

Inoltre, Apple conduce una revisione umana prima di inviare una segnalazione a NCMEC. Se il sistema contrassegna immagini che non corrispondono a immagini CSAM note, l'account non verrà disabilitato e nessun rapporto verrà inviato a NCMEC.

È possibile personalizzare CSAM per indirizzare altre cose o persone specifiche?

Il nostro processo è progettato per evitare che ciò accada. Gli hash delle immagini utilizzati per la corrispondenza sono presi da immagini CSAM note ed esistenti che sono state ottenute e convalidate da organizzazioni per la sicurezza dei bambini e lo stesso hash è memorizzato nel sistema operativo di ciascun utente iPhone e iPad, quindi gli attacchi mirati sono solo contro individui specifici Non abilitato dal nostro design e non vi è alcuna segnalazione automatica alle forze dell'ordine, Apple conduce una revisione umana prima di inviare la sua segnalazione e, nel caso in cui il sistema non sia in grado di contrassegnare immagini che non corrispondono a immagini CSAM note, l'account non sarà disabilitato e non verrà presentata alcuna segnalazione.

Le persone innocenti possono sbagliare a causa della funzione?

No, il sistema è progettato per essere estremamente accurato e la probabilità che il sistema segnali erroneamente un determinato account è inferiore a uno ogni trilione di account all'anno.Inoltre, ogni volta che un account viene segnalato dal sistema, Apple conduce una revisione umana prima di inviare la sua segnalazione a NCMEC e, di conseguenza, errori di sistema o attacchi non comporteranno la segnalazione di innocenti.

Fonte:

Questo articolo mi ha rassicurato in larga misura sul fatto che Apple o altri non sfruttano la privacy

Vedo che si tratta di un dettaglio e di uno sforzo fuori luogo. La prima cosa è che Apple intensifichi i suoi sforzi per risolvere il problema del consumo rapido delle batterie e aggiunga le applicazioni di cui l'utente ha bisogno e non rileva rispetto alle applicazioni Android. Ad esempio, possedevo un cellulare Lumia XNUMX XL ed è stato incluso nei programmi di sistema e senza la necessità di aggiungere un'applicazione o acquistare un sistema di registrazione delle chiamate E ripeto all'interno dei programmi di sistema, perché ad Apple non interessa cosa avvantaggia l'utente più che sprecare il suo tempo nella navigazione di applicazioni che pretendono di servire la società in un momento in cui vengono sollevati sospetti sul vero scopo dell'applicazione, come proteggere i bambini da immagini dannose!!!!???

La verità della questione è inquietante.

Apple non è né una stazione di polizia né un'agenzia di intelligence.

Ha dozzine di modi per aiutare i bambini.

Possiamo essere rassicurati se possiamo fidarci completamente di Apple e delle sue parole e dichiarazioni..ma..

Non credo che Apple o altri possiedano quell'assoluta onestà perché viviamo in un mondo pieno di bugie che sono governate da interessi!!

Grazie per questo bel argomento

Grazie dello sforzo

Una società dedicata alla lotta allo sfruttamento minorile

E le aziende interessate al caricabatterie 65 watt e 200 watt

E la fotocamera è da 108 pixel

?

Spero che tu stia bene e manterrai la privacy sull'iPhone

Inutile dire che ricordiamo al nostro caro lettore come la mela prende le decisioni, ed è semplicemente che dovrebbero essere studiate da tutti gli aspetti legali e pratici, soprattutto perché ogni mela fornisce un modello senza pari nella gestione della privacy e della sicurezza per l'utente.

Quindi, mia cara, crederesti che la mela sacrificherebbe la sua storia per il bene di una fotografia?

Questo servizio è ottimo e molto affidabile dopo una spiegazione così lunga nell'articolo, soprattutto per quanto riguarda la sicurezza dei bambini ed è facoltativo tra l'altro.

Se sei un sostenitore della teoria del complotto in ogni innovazione - e la maggior parte di loro sono nel nostro mondo arabo distorte dal sospetto - non ne hai bisogno, metti la sicurezza dei tuoi figli nelle mani dei veri cospiratori.

Se capisci cosa è stato detto, va bene almeno sperimentare o aspettare qualche anno per essere sicuro.

È meglio per noi sbarazzarci delle mentalità cospirative ed è meglio per noi capire i dettagli delle cose lentamente.È vero che siamo abituati a molte cospirazioni, ma per accecare l'intuizione da estendere a ogni nuovo arrivato, questo è la porta dell'arretratezza che va chiusa, e la questione dei vaccini corona non è lontana da quelle polemiche.

Se seguissi l'argomento, sapresti che non sono stati gli arabi a mettere qui le teorie della cospirazione

Ma i siti e gli account statunitensi stessi.

Penso che sia bello prendersi cura dei bambini Grazie Apple 👏🏻

السلام عليكم

Hai un problema, non so se è un problema o no

È un iPad 8 e funziona benissimo

Dopo aver aggiornato il dispositivo, probabilmente era l'aggiornamento 14.5, il suono delle notifiche è diventato debole

Quando entri nelle impostazioni e imposti una suoneria, il suono è molto forte e il suono dei giochi, di YouTube e di tutti i programmi

Ma quando imposti il tono per i messaggi, la posta o qualsiasi altra cosa, il suono è debole e anche il suono dei loghi

È per tutti i dispositivi o solo per il mio dispositivo o c'è qualcosa nelle impostazioni che deve essere modificato?

Questa non è una caratteristica

Quando i tuoi occhi sono sull'iPad, il suono della notifica sarà attenuato e quando lo schermo è chiuso o non ci presti attenzione, il suono della notifica sarà naturalmente alto.

Ok, e in caso di errore, Apple risarcisce gli utenti le cui foto sono state sottoposte a revisione umana e la cui privacy è stata violata visualizzando le loro foto senza permesso?

Saranno avvisati?

Non è la regola nelle leggi non cercare cose proibite se non in presenza di sospetti contro una determinata persona e per un motivo?

Esiste una legge che permetta e riconosca che il principio è quello di sottoporre tutti i contenuti a controllo e ispezione per tutte le persone, anche se si tratta di un controllo automatizzato?

I cittadini non sono uguali davanti alla legge? E gli utenti di altri sistemi?

Tutto è fatto da Apple Radi...# Insieme _ Oh _ Apple 🎧💪🏻

السلام جرا ورحمة الله

Come faccio a conoscere il Mac che studio su iPhone e come lo aggiungo al router?

ولكم جزيل الشكر

Vai alle impostazioni generali -> su

Riceverai un indirizzo WiFi

Inoltre, cerca su Google e ne troverai molti che spiegano cosa stai chiedendo.Penso che sia meglio disattivare l'indirizzo privato nelle impostazioni Wi-Fi perché imposta un indirizzo Mac diverso ad ogni connessione per proteggerti.