Apple 审查了将于今年晚些时候推出的 iPhone、iPad 和 Mac 的一系列新辅助功能。 Apple 表示,今年将推出新的软件功能,以提高认知、语音和视觉功能的可访问性。 这些功能很可能会包含在即将推出的操作系统中,首先是 iOS 17 更新、iPadOS 17 和 macOS 14。预计苹果将在 XNUMX 月初的 WWDC 大会上展示这些操作系统的预览版,什么时候正式推出。

辅助访问

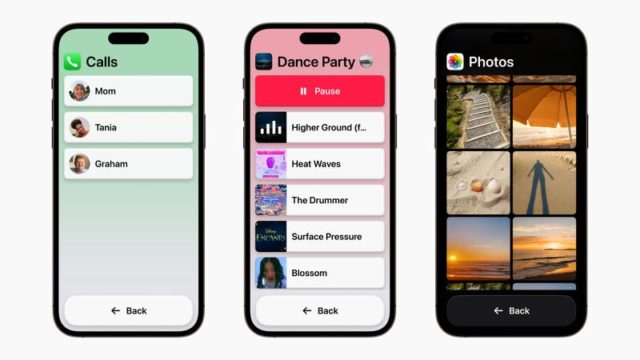

该功能通过专注于不同应用程序的基本功能来简化 iPhone 和 iPad 上的用户体验。 例如,它将呼叫应用程序和 FaceTime 合并为一个呼叫应用程序。 此外,它还包括其他基本应用程序,例如消息、相机、照片和音乐。 Assistive Access 提供了一个易于使用的界面,带有清晰易读的按钮和大文本标签。 它还允许用户通过在不同的布局之间进行选择来定制他们的体验。 他们可以在主屏幕上选择基于网格排列应用程序的视觉布局,也可以选择将应用程序排列成行的基于文本的布局。 目标是使用户界面更简单,更易于具有不同偏好和需求的个人使用。

实时语音和个人语音功能增强了易用性

Live Speech 是 iPhone、iPad 和 Mac 上可用的一项功能,它允许用户键入他们的消息或键入他们想说的话,然后这些书面文字或消息将在电话通话、FaceTime 通话和个人对话中转换为口头文字. 此功能对于说话有困难或更喜欢通过文本进行交流的个人特别有用。 此外,用户可以保存常用的短语,使他们无需详细输入即可轻松快速地参与对话。

对于有可能失去说话能力的人,例如那些被诊断患有肌萎缩侧索硬化症的人,Personal Voice 提供了一个很好的解决方案。 此功能允许用户创建与他们的声音非常匹配的数字语音。 要创建此自定义音频,用户遵循一组随机文本消息并使用 iPhone 或 iPad 录制大约 15 分钟的音频。

然后使用设备上的机器学习技术处理录制的音频,确保用户的信息安全并维护他们的隐私。 个人语音功能可以与实时语音无缝集成,允许用户在通话时使用他们的数字个人语音。 这种进展使个人能够保持熟悉和自然的说话方式,即使他们不再能够在身体上这样做。

放大镜的检测模式引入了对盲人或弱视用户的指点和交谈

iPhone 和 iPad 上的 Magnifier 应用程序中内置的 Point and Speak 功能旨在帮助用户操作包含多个文本标签的物理对象。 例如,当使用家用设备时,Point and Speak 结合了相机应用程序、激光雷达扫描仪和设备上机器学习的功能。 当用户在设备键盘上移动手指时,Point and Speak 会识别现有文本并实时大声读出。 此功能允许用户接收听觉反馈并更有效地与设备交互。

Point and Speak 与 VoiceOver 兼容,并与其他放大镜功能无缝协作。通过使用 Point and Speak,用户可以访问实时信息,允许他们与对象交互、识别人物、识别门以及获取图像描述。导航他们的更有效地改善物理环境,所有这些都有助于改善和高效的出行体验。

ميزاتإضافية

◉ 专为 iPhone 设计的助听器可以直接连接到具有自定义功能的 Mac。

◉ 语音控制建议语音替代方案来编辑文本,并帮助语音作者。

◉ 语音控制为输入文本提供语音建议,帮助使用语音输入的用户在众多发音相似的单词中选择正确的单词。

◉ 语音控制指南提供使用语音命令代替触摸或打字的提示和技巧。

◉ 开关控制可以将任何开关变成虚拟视频游戏机。

◉ 调整文本大小在 Finder、信息、邮件、日历和备忘录等 Mac 应用程序中最为简单。

◉ 为对快速动画敏感的用户自动停止消息和 Safari 中的动画。

◉ Siri 的语速可以从 0.8x 到 2x 自定义。

◉ 快捷方式获得“记住这个”操作,允许有认知障碍的用户在 Notes 应用程序中创建视觉备忘录。

相片:

9条评论